Auditar o identificar problemas relacionados con el SEO es el primer paso para posicionar adecuadamente un sitio web. Identificando los problemas podremos plantear soluciones adecuadas para corregir estos puntos débiles y reforzar nuestros aciertos.

Análisis en los Motores de Búsqueda

El primer paso es verificar que la información de nuestro web esta indexada correctamente en los motores de búsqueda.

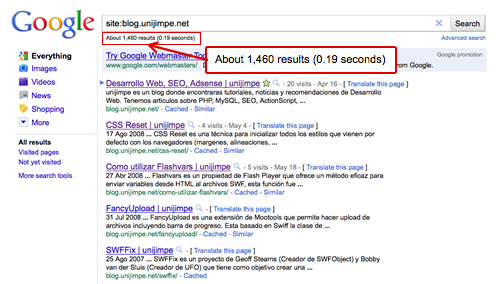

- Busca en Google:

site: tudominio.com, esto devolverá todas la páginas indexadas de tu dominio. Compara el total de páginas indexadas con el total de páginas que tienes alojadas en tu servidor. - Prueba buscar el nombre de tu web o marca y verificar tu posición en los buscadores. Si no existen resultados de tu web es probable que hayas sido penalizado.

- Revisa la versión en cache que tienen los buscadores y verifica que sea la misma versión de tu página actual, si no es así entonces el buscador tiene indexado una versión antigua de tu página.

Análisis Contenido Duplicado

Verifica que tu dominio tenga canonicalización. Es decir que la versión no-www (http://tudominio.com) de tu web haga una redirección 301 a la versión www (http://www.tudominio.com) o viceversa. Si no existe esta redirección 301 ambas versiones puedes considerarse como dominios diferentes y una considerada como contenido duplicado.

Para hacer una revisión de contenido, realiza la búsqueda exacta de una frase (Entre comillas dobles) que se encuentre en tu web y analizar la cantidad y tipo de resultados devueltos. Tambíen puedes utilizar el la palabra clave intitle para indicar la búsqueda solo en los títulos.

- Buscar en el contenido:

"Frase a buscar" - Buscar en los titulos:

intitle: "Frase a buscar"

Si tienes varias páginas con el mismo contenido, puedes utilizar la propiedad canonical para indicar a los buscadores cual de estas páginas debe ser considerada como contenido original:

<link rel='canonical' href='http://blog.unijimpe.net/depurar-flash-con-firebug/' />

Análisis de los URLs

Revisar que los URLs de tu página sean cortos, limpios y descriptivos (Descriptivos: que contienen keywords indicadores del contenido hay en la página). Evitar incluir parámetros adicionales como identificadores, códigos de sesión entre otros. En resumen los URLs deben ser sencillos de recordar y deben indicar directamente el contenido que están alojando.

Ejemplos:

- Incorrecto:

http://blog.unijimpe.net/?p=1268 - Correcto:

http://blog.unijimpe.net/depurar-flash-con-firebug/

Análisis de la etiqueta <title>

Asegúrate que todas las páginas tengan títulos únicos y descriptivos. Recuerda que los títulos deben ser únicos pues de lo contrario los motores de búsqueda no distinguirán la diferencia entre las diferentes páginas. Deben ser descriptivos de forma que explique sin opción a dudas cual es el contenido de la página.

No es necesario incluir el nombre de tu marca en el titulo, pero si deciden hacerlo debe ser al final de titulo y con un carácter separador, esto para obtener mejores beneficios en el ranking de los buscadores. Además hay que verificar que los títulos deben ser de menos de 70 caracteres de longitud en lo posible.

Análisis de los Metatags

Revisa el metatag robots en todas las páginas de tu sitio. Ten en cuenta que si el metatag robots tiene asignado el valor NoIndex o NoFollow evitará que tu contenido sea indexado en los buscadores. El uso no intencionado de estos tags hará que el contenido no sea indexado. El siguiente código debe ser utilizado sólo cuando se quiera evitar que la página sea indexada, por ejemplo cuando el contenido es accesible sólo para usuarios registrados.

<meta name="robots" content="noindex, nofollow" />

También es necesario revisar que el metatag description sea único y contenga un resumen del contenido de la página. El contenido de este tag será mostrado en los resultados de la búsqueda por lo que ayuda a los usuarios a obtener una idea del contenido de nuestra página. Si no puedes crear un resumen de la página elimina el metatag description y Google hará un resumen automático.

<meta name="description" content="resumen del contenido de tu pagina " />

Analisis de robots.txt y sitemap.xml

En el archivo robots.txt se incluye un listado de las páginas o archivos que incluir o bloquear según el tipo de buscador. Es necesario verificar que este archivo no contengan enlaces que deseamos sean indexadas.

El archivo sitemap.xml es un documento XML que contiene todas las rutas con su respecto intervalo de tiempo a rastrear que deseamos enviar a los buscadores. Revisar que todas nuestras páginas estén incluidas con el intervalo de tiempo adecuado.

Para analizar estos dos archivos pueden utilizar las herramientas de Google Webmaster Tools.

Análisis de Redirecciones

Los buscadores interpretan el contenido de nuestra página pero no interpretan javascript, por lo que las redirecciones se deben hacer utilizando headers a nivel de servidor de lo contrario los motores de búsqueda no llegarán a la página de destino. Además de ello si se hace una redirección esta debe ser del tipo 301 para indicar que el contenido ha sido movido definitivamente a la nueva dirección. También hay que evitar el uso excesivo de las redirecciones pues estas incrementan el tiempo de carga de la página debido al tiempo que se toman los servidores para resolver las direcciones.

Se puede utilizar la herramienta HTTP Redirect Viewer para el análisis del tipo y cantidad de redirecciones.

Análisis de las Enlaces Internos

Revisa que las páginas no tengan enlaces excesivos. Google informa que se debe utilizar una máximo de 100 enlaces por cada página, por que debes incluir sólo las páginas que consideres mas importantes para no exceder es límite.

También es necesario verificar el uso correcto de los textos anchor en los enlaces internos. Esta es una oportunidad para informar a los usuarios y motores de búsqueda el contenido del enlace de destino, por lo cual debes elegir correctamente el texto del enlace.

<!-- incorrecto --> <a href="contacto.php">Click Aquí</a> <!-- correcto --> <a href="contacto.php">Formulario de Contácto</a>

Tener en cuenta que Google no interpreta Javascript por lo cual los enlaces hechos de esta forma no serán interpretados y los buscadores nunca llegarán a la página de destino.

<!-- incorrecto --> <a href="javascript:showContact();">Formulario de Contácto</a> <a href="#" onclick="showContact();">Formulario de Contácto</a> <!-- correcto --> <a href="contacto.php">Formulario de Contácto</a>

Si tus visitantes pueden publicar comentarios u otro tipo de contenido que incluyan enlaces, utiliza el la propiedad rel=»nofollow» para evitar que estemos enlazando a sitios de baja calidad o sitios de spam lo que afectaría negativamente nuestro posicionamiento.

<a href="http://spam-site.com" rel="nofollow">Spammer Site</a>

Análisis del Tiempo de Carga

Si el tiempo de carga de tu página es excesivo los motores de búsqueda lo considerarán como un factor en contra y en el peor caso no lo indexarán debido a la dificultad para acceder a nuestra información. Para hacer un análisis de la velocidad de carga se puede utilizar el plugin para Firebug YSlow o también la herramienta online Page Speed Online de Google.

Para resolver este problema, revisa que las imágenes de tu web no sean muy pesadas, utiliza los headers de expiración, minifica tus archivos js y css, utiliza gzip para enviar contenido. Para mas tips para acelerar la velocidad de carga pueden leer Optimizar Carga de Paginas Web.

Análisis del Código HTML

Los motores de búsqueda interpretan nuestra página como un texto plano y los tags HTML indican la forma como debe ser interpretado, pero estos no pueden interpretar imágenes, vídeos, flash. Interpretan texto pero no tienen la capacidad de interpretar código Javascript por lo cual lo que vemos en pantalla no es necesariamente lo que puede ser interpretado por el motor de búsqueda.

Entonces hay que asegurarse que nuestro código HTML sea redactado adecuadamente y muestre al buscador el contenido correcto de nuestro web. Se puede hacer un análisis de como interpretan los buscadores una página con SEO Parser la cual esta en estado beta pero que permite hacer una análisis de como nos ven los buscadores.

Mas Información

- The Art of SEO – Chapter IV: Auditing an Existing Site to Identify SEO Problems

- Demystifying the «duplicate content penalty»

- Specify your canonical

- Acerca de rel=»nofollow»

- Optimizar Carga de Paginas Web

Comentarios Total 11 comentarios

Publicado: 06/06/2011 7:30 am

Gran post. Mi enhorabuena por el artículo y por el blog en general.

Un saludo.

Publicado: 22/12/2011 12:30 pm

excelente articulo!

gracias!!!

Publicado: 05/01/2012 2:08 am

Excelente informacion potencial junta, principalmente por la redireccion 301 que suele ser un error comun y gravemente penalizado

Publicado: 09/03/2012 12:51 pm

Wow, excelente post, he leído todo y puedo dar fe de su gran aporte, sin tapujos aquí esta todo lo que deberíamos hacer en nuestro sitio web. Aconsejo que el title de cada página sea bien descriptivo no títulos muy cortos, trata de incluir la palabra clave que desees posicionar en el titulo y en la description, la description que sea bien llamativa e informativa, recordar que esta es la que ven las personas cuando realizan la búsqueda y la que nos ayuda a decidir si entrar o no al sitio.

Saludos!!

maquetacion web

Publicado: 30/03/2012 10:49 pm

Excelente síntesis.

También tenemos que tener en cuenta que el nivel de optimización depende en parte de lo que haga o no nuestra competencia.

En un rubro muy difícil sí será necesaria una total optimización. Y, si nuestro nicho tiene muy bajo nivel, no sería tan necesario hacer una optimización demasiado rigurosa.

Publicado: 05/10/2012 3:36 am

Yo añadiría en el titulo para Webs no CMS, en CMS habría que añadir alguna que otra cosa más.

Recuerda que hoy por hoy la mayoría de páginas son blogs.

Un saludo

Publicado: 05/10/2012 10:05 pm

Mi pregunta es . Tengo mi web que recibe gran parte de visitantes pero por sus imágenes como puedo hacer que entren a mi web ya que las imágenes estan bien optimizadas y entran mediante el google images

Publicado: 12/03/2013 3:00 pm

Hola! Tenemos un problema con una pagina web, que tiene un dominio (.com) pero con contenido Español.

Antes el mismo dominio en 2007-2008 era una pagina web chino, despues lo compramos en 2011 y ya subimos contenido en 2012. La web ha obtenido pagerank 2 en solo 4 mese. Mi pregunta es si pones en google.es la palabra ( solo el nombre de dominio sin puncto com ) no sale la pagina. Si buscas lo mismo en google.com o google int china, si que sale perfectamente!!!

Que hay que hacer en este caso que google no se confunda mas, y que se de la cuenta que la pagina es para España aunque tiene .com ??? En la meta hemos puesto metatag lang “ES”… Que mas se puede hacer?

Muchas Gracias! Espero vuestr@ respuesta. Un Saludo!wc

Publicado: 12/01/2014 2:00 pm

Excelente aportación, aun vigente y fácil de entender. Sería bueno abordar el tema del robot.txt ahora que google webmaster tools esta introduciendo una sección especial en el rastreo para los smartphones. Gracias por compartir.

Publicado: 27/04/2014 12:45 pm

excelente, excelente!

Publicado: 16/10/2014 7:53 pm

Muy buen artículo, muy util para los que nos dedicamos al diseño web, gracias por compartirlo.